“小米首款 AI 眼镜,不仅是面向下一个时代的个人智能设备,更是随身的 AI 入口。”

智能眼镜凭借 “视觉 + 语音” 双通道多模态感知的先天优势,已然成为下一代智能化体验的核心载体。当技术触角延伸至咖啡厅的嘈杂对话、交流会的观点碰撞等复杂场景时,交互痛点便愈发凸显:硬件算力跟不上算法复杂度、容易被旁人误唤醒、发声主体识别模糊、远场收音时抗干扰能力弱;同时,在图片知识问答以及图片翻译场景中,在低传输延迟的前提下,如何保证模型效果高准确率是功能实现过程中的最大难题。

技术理想与用户期待之间,横亘着多重壁垒,而突破这些壁垒,正是解锁智能眼镜 “前所未有体验” 的关键所在。

01

软硬件结合

有效抑制误唤醒

当 “小爱同学” 被旁人无意触发,当环境杂音干扰设备精准判断,用户对 “设备只听主人令” 的需求愈发迫切。智能设备误响应非佩戴者指令,堪称影响交互体验的 “顽疾”。如今,小米 AI 眼镜给出了一个务实且有效的解决方案 —— 通过 VPU 硬件与唤醒模型的深度耦合,辅以前端 BF 算法的定向增强技术,构建起双重防护的 “声学结界”,让智能交互更精准。

▍VPU加持,显著提升语音交互准确性

传统麦克风方案在复杂声场中常陷入困境 —— 无法有效剥离环境噪声与目标语音,而 VPU(语音拾取单元) 的引入实现了突破性进展。其核心优势源于骨传导信号的物理特性:声音通过颅骨振动直接传输,从源头过滤空气传播的环境杂音,仅保留佩戴者的语音特征。

这种 “纯净提取” 能力,为区分 “主人声” 与 “干扰声” 提供了独特的硬件基础,如同为设备装上了 “专属听觉过滤器”,提供了独特的硬件基础。设备在纷繁复杂的声音环境中,能精准捕捉到佩戴者的语音信号。

在提升佩戴者语音交互准确性方面,当用户佩戴小米 AI 眼镜,“小爱同学” 被唤醒词触发时,准确区分语音信号来源是关键。但实践中存在硬件局限,无法完全依靠 VPU 判断非佩戴者语音,单纯使用 Mic 阵列也难以有效区分。

那么,应该如何解决 “谁在唤醒” 的识别难题?研发团队采取了针对性解决方案:一是寻求最佳特征组合,通过分析与筛选多种语音特征,找到最能有效区分佩戴者与非佩戴者语音的声学特征组合;二是采用 VPU 分频段与 VPU/MIC 对之间的相干特性相结合的方式,利用分频段处理及相干特性分析,提升区分能力,更好地抑制非佩戴者语音信号,让 “主人指令” 成为唯一触发源。

▍多波束技术,实现定向拾音精准化

BF 算法(波束形成算法) 作为音频信号处理的核心技术,通过调控多麦克风阵列的信号相位与幅度,形成指向性 “声音波束”,实现对目标方向声音的增强与干扰方向的抑制。在小米 AI 眼镜中,这一算法与 VPU 协同,针对不同场景实现精细化优化。

当 VPU 信号与唤醒模型深度结合,通过精准对比判断,能在绝大多数场景下识别非用户唤醒指令;再搭配 BF 算法对非佩戴者语音强度的有效抑制,双重维度为用户筑起 “防打扰壁垒”。

除了抑制误唤醒,BF 算法与 VPU 的协同,还能解决复杂场景下的拾音精准性问题 —— 比如同传翻译时,如何清晰捕捉对方声音同时过滤自己的说话声。在该场景中,由于佩戴者在翻译过程中有交流或提问需求,技术需准确区分佩戴者与非佩戴者声音,增强外部需翻译音频,同时抑制佩戴者语音。但该需求实现存在困难,VPU 在播放时产生的振动会影响判断准确性,且单纯依靠 4 个麦克风构成的波束,因正常 4 个麦克风的波束宽度和衰减能力存在局限,大致只能覆盖 30 度范围,衰减 15-20dB,很难做到波束足够窄且衰减足够大(需大于 40dB)。

对此,研发团队采用的解决方案是通过 4 个麦克风构成 2 个波束,让设备在多人对话中,哪怕旁人提到“小爱同学”,也能精准锁定你的指令;若对方在你侧面或身后说话,也能清晰拾音,避免翻译漏听。最终实现对非佩戴者声音的全方位抑制,提升非佩戴者的语音拾音效果。

02

低功耗设计

8.6 小时全天候陪伴

续航能力对于智能穿戴设备而言至关重要。频繁充电不仅增加使用成本,更会割裂用户的连续体验。如何提升待机时长,减少频繁充电的问题?

小米 AI 眼镜采用了软硬件结合的低功耗设计,有效提升了设备的待机时长。

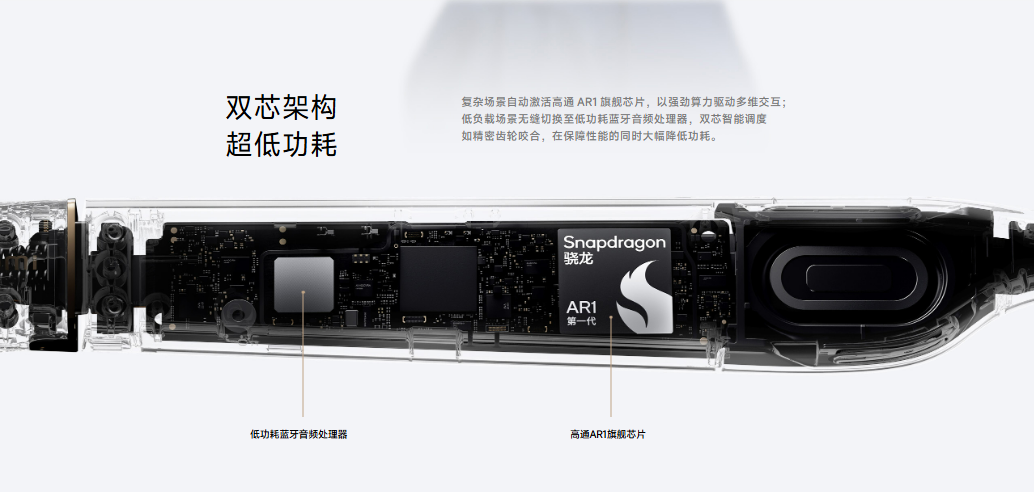

在硬件层面,小米 AI 眼镜采用高通 AR1 旗舰芯片作为主控芯片,并搭配低功耗蓝牙音频处理芯片,构建起 “一机双芯” 的异构计算平台。通过任务负载的智能分配,将音频信号实时处理、语音唤醒监测等需持续运行的轻量级任务交由低功耗芯片独立承载,既显著降低了设备待机状态下的功耗水平,又为主控芯片释放了充足算力资源,确保其能稳定支持多维度功能的流畅运行。

在软件层面,研发团队通过端侧 AI 模型的轻量化重构与音频处理算法的深度效能优化,在保持核心识别精度不下降的前提下实现了能耗的精准压缩。依托软硬件协同的深度优化策略,小米 AI 眼镜的典型使用续航时长达到 8.6 小时,可全面覆盖日常通勤、办公协作及户外出行等多场景使用需求,有效缓解用户的 “电量焦虑” 问题。

03

多模态大模型赋能

打造 “交互无感” 特色能力

解决误唤醒与续航问题后,如何让设备“看懂世界”并快速响应,成为突破体验上限的关键。这既需要设备具备 “看懂” 的能力,更要在复杂场景中实现 “秒懂” 的效率。

研发团队给出的答案是:依托小米自研多模态大模型技术,突破功能边界,实现 “所见即所得、所问即所答” 的智能体验。

为达成这一目标,首先要跨越智能眼镜固有的技术门槛:高清图像传输延迟高,大模型效果又严重依赖高清图像,形成 “速度与精度” 矛盾;且算力、延迟、精度的 “不可能三角” 难以通过单一端侧或云端突破。基于此,研发团队专为眼镜设计端云结合的图像问答大模型架构,分工协作破解难题。

▍端侧:轻量化模型 + 智能裁切

眼镜本地部署轻量级 ROI 区域检测模型,结合用户意图完成复杂计算,精准裁切关键区域后传输至云端,蓝牙传输延迟控制在百毫秒级,满足即时反馈需求。

- 关键 ROI区域检测:通过参数精简、模型量化等技术,在低算力下精准锁定用户兴趣区域,平衡检测精度与资源消耗;

- 基于意图的智能裁切:结合语义理解与 ROI 区域检测结果,自适应调整裁切范围,去除冗余信息、保留关键内容传输到云端,既保障传输速度,又为云端精准问答奠定基础。

▍云端:千亿参数大模型精准应答

云端大模型接收到端侧感知信息后,会结合用户意图,调用多垂类超千亿参数的多模态大模型,进行信息深度解析,对用户的意图进行分类和回答,使用户能以自然语言直接询问所见场景,实现“可见即可问”的智能交互。研发团队针对端云结合架构,设计了结合端侧信息的多任务学习模型训练方案。

- 端侧信息自适应增强训练:在多模态训练数据中融入端侧信息,同时设计针对性学习任务,让模型在训练中充分理解端侧信息,并能自动判断端侧信息的合理性,在实现端侧信息有效利用的同时避免错误信息的误导。

- 困难图片的针对性提升训练:在训练视觉编码器时引入模糊等困难图片样本,通过放缩、高斯模糊等实现对端侧困难图片的模拟,并在训练中调整不同困难图片的比例,提升大模型对困难图片的感知能力。

这种“端云结合”的架构,既突破了硬件算力限制,又实现了“极速响应+超高精度”的体验平衡,让智能眼镜通过技术架构创新,实现了“万物可识”从概念到日常的转变。

▍AI 眼镜图像问答:核心场景体验

- 多模态翻译/阅读:镜头所至,语言无阻

AI 智能眼镜巧妙融合 OCR 文字识别与手指检测引擎,在多模态翻译/阅读场景下,实现“抬眼看世界,耳边有答案”的交互体验。当面对外语菜单时,用户仅需发出“拍照翻译”等语音指令,系统便会迅速且自动地完成“拍摄→识别→翻译→语音播报”一系列操作,实时精准输出翻译结果,打破语言与信息壁垒。

- 多模态场景问答:一眼看穿万物奥秘

面对陌生物体想快速了解?AI 眼镜能一眼识别。依托百万级物体数据库(覆盖车型、动植物、电子产品等),AI 眼镜可实现 95%+识别准确率,并支持云端数据实时更新。不论是街头遇稀有跑车、公园见奇特花卉,眼镜均可即时解析,让 “万物皆可识” 成为日常。

从 “只听主人令” 的精准交互,到“8.6 小时”的续航,再到 “所见即所答” 的智能体验。小米 AI 眼镜的每一项技术突破,都在回应着用户对智能设备 “更懂需求、更贴生活” 的深层期待。

当智能设备从 “功能工具” 进化为 “贴身助手”,细节处的技术打磨往往决定着体验的跃升。小米 AI 眼镜以硬件创新为基、以算法优化为翼,正推动智能穿戴设备向“自然交互、无缝融入” 的理想形态加速迈进。