诠视科技(Xvisio Technology,上海诠视传感技术有限公司)近日推出了一款功能强大的空间感知交互模组级产品SeerSense™ DS80。该产品集诠视科技多年研发成果于一体,是继其在美国AWE期间向业界推出的SeerLens™ One AR眼镜之后面向行业元宇宙空间感知交互应用的又一重要布局。

高度集成,即插即用

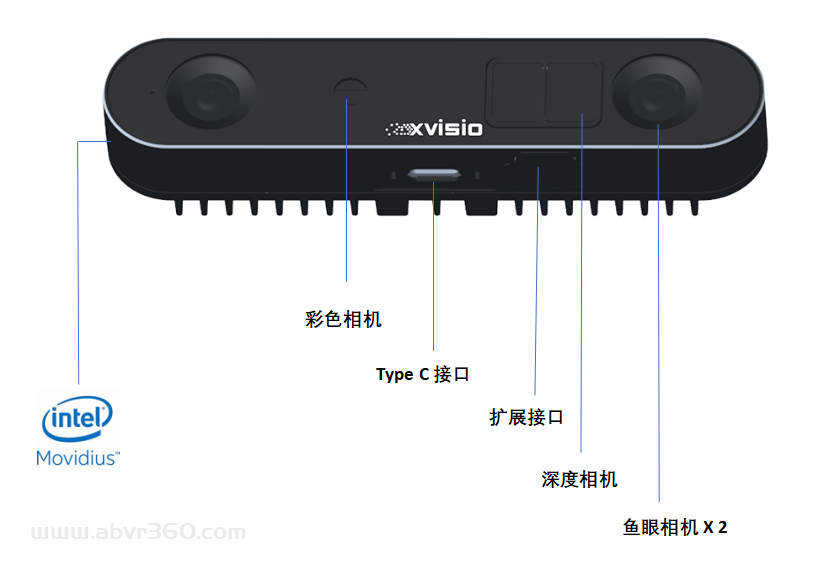

SeerSense™ DS80 是目前业界唯一的集双目深度引擎、TOF引擎、VSLAM引擎、AI引擎、视频编码引擎于一体的智能感知模组产品。在产品设计上,兼顾了被动双目视觉与TOF深度感知能力的优势,实现能力互补。基于本地化处理的VSLAM引擎、双目深度和TOF深度计算引擎、AI推理引擎,摆脱了对系统算力的依赖, 即插即用。功能丰富的VSLAM SDK可以面对复杂的作业场景。基于独立硬件单元的CNN引擎,可适配本地的多种视频源输入,包括:鱼眼相机、TOF相机、RGB彩色相机,实现本地的实时AI推理计算,并可部署多个模型做并行处理。与其空间感知能力结合,可支持场景识别与空间语义分割,是理想的AIOT终端设备。基于硬件的H.265视频压缩功能, 大大节省传输带宽。丰富的图像处理能力及完整的多相机内外参标定,支持广泛视觉传感的应用,适配Open CV和Open VINO开源社区,用户可快速将离线训练的模型利用该工具链部署到模组本地。并可利用Open Model Zoo里的数百个模型对应广泛的应用场景,大大缩短研发周期。通过USB Type C 接口与主控设备连接使用。可通过扩展接口接入激光雷达等其他传感器,以及多机级联的使用,具有高度的扩展性。

SeerSense™ DS80随机提供的的开发工具包括

-

XRobot Foundation SDK 软件开发工具包

-

XRobot Foundation Viewer 演示工具

-

XRobot Foundation Firmware 固件升级工具

-

Open VINO 模型转换及部署工具

SDK支持Windows,Linux,Android操作系统,同时提供各类Wrapper API 以便对应不同产品的应用开发。例如ROS/ROS2,Unity,C/C++,Python,Java JNI。

该产品通过了CE、FCC、RoHS的认证,以及CB、FDA的Class I激光安全认证, 适用于海内外工业、医疗,安防,教育,办公,文娱,家用的各类产品市场。

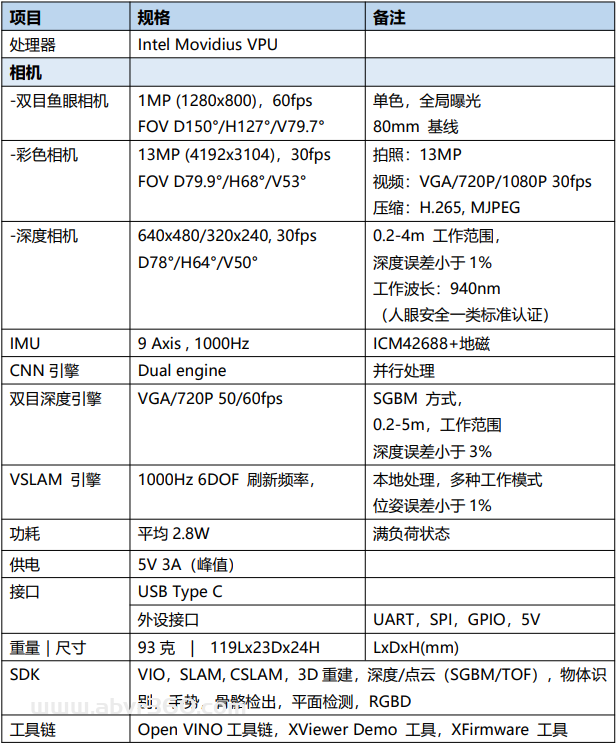

产品规格

SeerSense™ DS80 产品规格

SeerSense™ DS80融合了三大核心空间感知能力 ,即VSLAM能力,深度感知能力,AI推理能力。实现了器件级本地化部署,极大地降低了用户开发和使用的门槛。

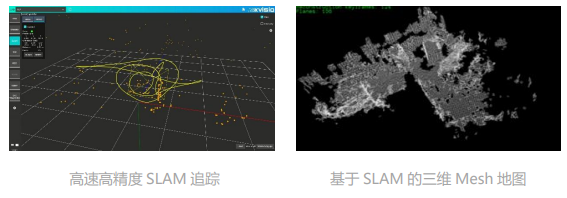

1) VSLAM(Visual SLAM)是基于视觉的SLAM(Simultaneous Localization and Mapping, 即时定位与建图)系统,是一个利用图像传感器获取空间的特征信息,在生成增量地图的同时,定位自身的位置与姿态的技术。属于多视角几何计算领域的应用,对算法和算力要求颇高。是机器人和AR/VR领域的底层技术,一直是被业界高度关注的热点。诠视科技在2018年在业界首次将其多年研发的算法与高算力芯片结合,面向业界推出了基于Intel Movidius VPU的VSLAM传感器模组eXLAM80,并获得了美国2018 CES Innovation Award。在此之后,2019年Intel Realsense推出了类似产品Realsense T265,成为市场上仅有的两大器件级VSLAM解决方案,开启了VSLAM器件1.0时代。

此次诠视科技打造的SeerSense™ DS80是eXLAM80的升级版,采用了Intel Movidius Myriad X VPU,大幅提升了上一代产品的VSLAM的处理能力。除了高速高精度独立VIO模式,还支持SLAM,CSLAM,以及端云结合的部署能力,实时回环检测模式等多种工作模式。增加了高速二维码辅助定位及空间锚点的功能。 充分发挥了多传感器融合的优势。

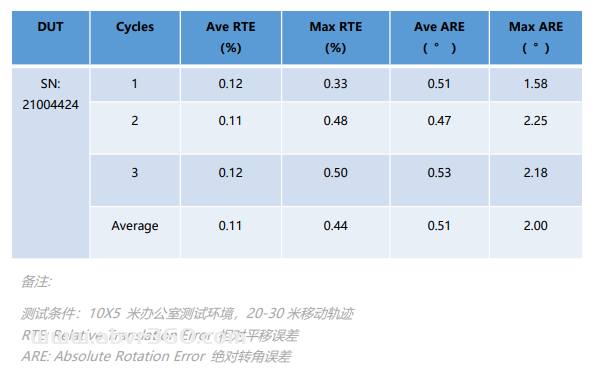

空间定位精度测试报告

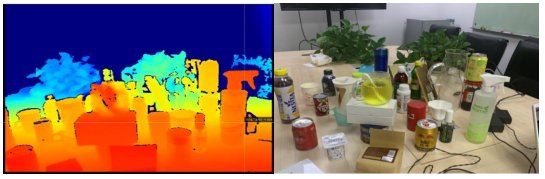

2) 深度感知是空间感知的基础能力,SeerSense™ DS80除了基础的双目视觉深度引擎,还搭载了业界领先的SONY VGA 分辨率iTOF 深度传感器,TOF的深度检出是基于光子的飞行时间,比双目视觉深度引擎测距精度更高。SeerSense™ DS80实现了在模组端的深度解析及滤波处理。采用940nm的工作波长,可有效抑制近红外波长的干扰,帧率可达30fps,在0.2-4米的范围内的误差小于1%。可以输出深度图,空间3D点云图,IR灰度图。根据工作范围,可选用单频和双频模式。单频模式有效工作距离为1.5米, 双频可达4米。可用于深度检测,物体三维测量,三维环境建模。

高精度TOF 深度图

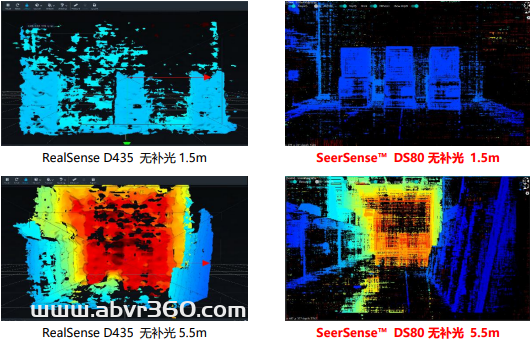

针对室外强光的环境及多机干扰的环境,可使用SeerSense™ DS80搭载的双目深度引擎。该引擎的特点是高分辨率,大视场角,高帧率。有效水平视场角可达110°,帧率可达60fps,分辨率可达1280 X 720,工作距离可达5.5米。在有效工作范围内,误差小于3%。精度略低于TOF传感器。以下是Seer Sense™ DS80与Intel RealSense D435在被动双目测距下的对比数据 (图中两款产品的视场角有差异,SeerSense™ DS 的视场角更大)。

两个深度引擎均可与VSLAM引擎同时工作,空间追踪定位的同时,实现对物体深度的实时检出。可以有效地实现三维建模、导航、定位、避障的能力。

3)AI引擎的本地化可以有效地利用本地的多个摄像头输入的能力以及与VSLAM和深度引擎的组合,部署各种智能化的功能。包括三维手势识别与追踪,人体骨骼提取,三维人脸防伪识别,三维物体识别与空间分割,场景识别等。用户可以利用OpenVino离线模型训练工具实现训练及导入面向场景的模型,在SeerSense™ DS80上实现了即插即用的便利。

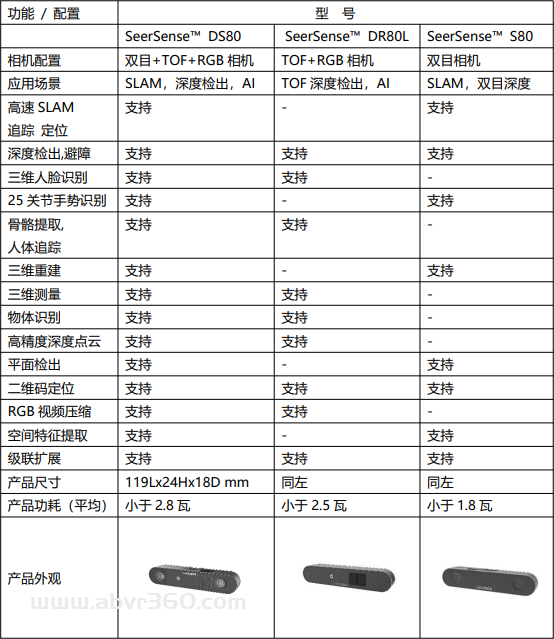

系列产品,全域覆盖

SeerSense™ DS80 还拥有两个简化版,分别为面向人脸识别应用的SeerSense™ DR80L和单纯定位追踪的SeerSense™ S80。

产品系列

赋能行业,应用广泛

Seer Sense™ DS80 可广泛应用于工业,安防,医疗,物流,零售,办公,影视等广泛领域,是元宇宙及AIOT应用的基础感知单元。

SeerSense™ DS80的应用场景

对现实空间的理解与重构是通向元宇宙的第一步。诠视科技从创立之初就坚持算法与硬件相结合,从底层传感器到产品平台的发展路径,打造了全链条的核心技术与产品部署能力。“创新机器视觉感知能力,超越人类视觉极限”,是诠视科技团队的共同愿景。作为一家引领全球空间感知交互技术的高新科技企业,诠视科技砥砺前行,近期将有一系列新产品发布。敬请关注“诠视科技”公众号,获取最新资讯。

原文始发于微信公众号(诠视科技):诠视科技重磅推出新一代空间感知交互模组SeerSense™ DS80,布局元宇宙感知交互底层能力