Esther|编辑

在渲染、捕捉高清3D场景时,开发者通常采用建模,或用专业3D捕捉等方式,整个流程工作量大、耗时久。NVIDIA科研人员曾指出,近年来图像渲染速度越来越快,渲染模型的训练速度也在加快,已经看到越来越多人利用AI来替代传统计算机图形方案。

因此为了快速获得大量3D场景,谷歌等公司开始探索用NeRF(神经辐射场)模型来合成的方案。比如,谷歌此前已经用NeRF模型将2D图像合成具有立体感的视频,或是根据文本来生成可360°查看的3D虚拟物体。

不过,现有的NeRF算法合成3D图像的视角和深度有限,很难渲染出没有边界的大规模场景,也无法从任意角度查看。换句话说,利用NeRF模型合成的3D场景看起来像是用摄像头对着一个方向移动拍摄的效果。

为了进一步扩大3D场景和模型合成的规模,谷歌科研人员近期训练了一个新的AI模型:mip-NeRF 360。该模型在NeRF基础上可渲染出完整的3D物体和场景,支持从任意视角观看,相当于渲染出完整的3D虚拟空间。而这项技术,将有望加速VR内容开发、仿真培训等场景。

那么,为什么谷歌要开发mip-NeRF 360?它传统的NeRF技术有哪些不同?

传统NeRF模型的延伸

据了解,NeRF是一种深度渲染方法,它使用一个MLP人工神经网络去隐式学习一系列静态图像,并用体积去表示图像中的物体,合成全新的视角。实际上,NeRF通过将特定场景类型与适当的 3D 参数来模拟自然的远近景比例,原理有点类似于光线追踪技术。

传统的NeRF模型是基于多张输入图像来优化的,如果要合成输入图像中没有的新视角会存在一定局限,准确性也不够理想。由于场景中远处和近处的细节和比例不平衡,NeRF模型渲染出的场景可能会存在模糊、低分辨率等问题,训练模型的速度也很慢。而NeRF模型利用少量图像来重建大场景时,可能会出现锯齿。

为了改善这一问题,谷歌科研人员提出了mip-NeRF 360,一种基于NeRF的延伸模型,旨在优化图像采样和混叠的效果。mip-NeRF 360特点是可渲染场景中每一点的360°视角,比mip-NeRF的均方误差降低54%,可合成逼真的视图,以及高度复杂、细节的大场景深度图。

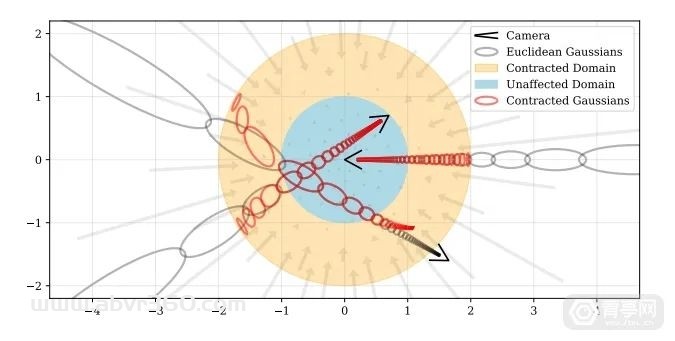

简单来讲,mip-NeRF是对NeRF的一种扩展,区别是NeRF将3D点以射线的形式排列来进行建模,而mip-NeRF则采用椎体的形式。mip-NeRF 360是在mip-NeRF基础上再次扩展,其特点是可合成无边界感的场景,这些场景可从任何方向和距离查看。

渲染复杂的场景

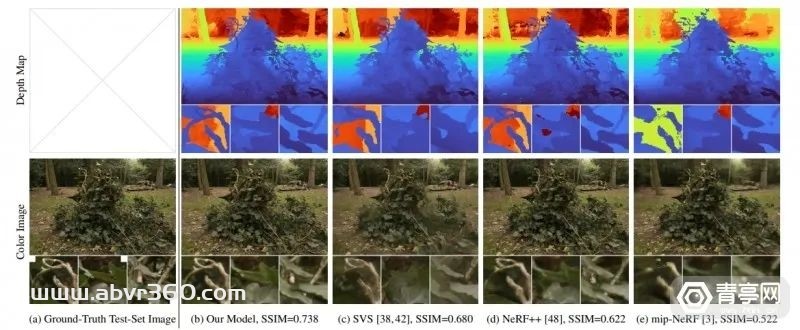

通过mip-NeRF 360,谷歌科研人员可合成与背景独立的3D模型,因此可替换背景。此外,也希望渲染出大规模的场景,这个场景可以从任意角度和方向来查看,场景中的内容可以设置在任意距离。相当于用AI合成一个3D游戏中的完整场景。此前的研究显示,基础的NeRF模型难以这样的渲染效果,其渲染的3D场景存在边缘模糊等问题。

NeRF算法通常只能合成有限规模的3D场景,越靠近场景边缘图像越模糊、分辨率越低并且存在锯齿,看起来就像是某种边界,效果不自然。因为NeRF算法没有正确学习远近处物体的自然缩放比例,所以在渲染不同分辨率视图时容易产生锯齿。NeRF渲染的场景仅能合成有限的视角,而且近景和背景的结构需要足够简单,如果太复杂合成效果不理想。

在此基础上的mip-NeRF模型可准确渲染3D物体,但其生成的背景通常较模糊,近景也不够细致。

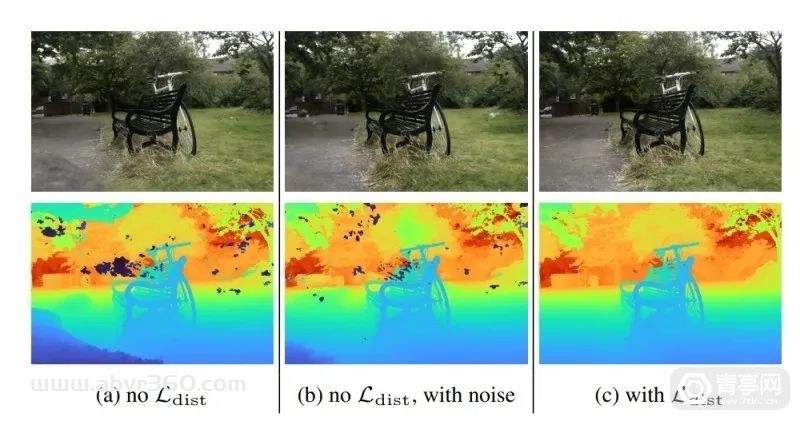

相比之下,mip-NeRF 360方法可采集到逼真的360°视频数据,其中包含了背景中的草、树叶等细节,而且场景中包含细致的深度信息。另外,mip-NeRF 360在NeRF基础上改进了训练方法,分别利用粗和细光线间隔对场景进行采样。

科研人员表示:mip-NeRF 360 效果比以往的NeRF模型更好,而且比mip-NeRF的均方误差减少了 54%,训练时间仅增加了 1.92 倍。此外,该模型不需要外部训练数据,也不需要生成MVS(多视图立体)代理几何模型。相比之下,mip-NeRF 360会生成非常详细的深度图。

不过,mip-NeRF 360还有一些需要优化的方面,比如:目前主要用于合成近距离视角,距离图像中心远的质会下降。此外mip-NeRF 360的训练时间和训练NeRF架构一样需要几个小时。

一些薄的结构和精细的细节可能会被遗漏,例如自行车轮胎的细节,或者树叶上的纹理。在视角远离场景中心时,视图合成质量可能会下降。而且,与大多数类似 NeRF 的模型一样,场景合成算法需要在加速器上进行数小时的训练,因此很难在计算机等设备上本地运算/培训。

参考:

https://jonbarron.info/mipnerf360/

原文始发于微信公众号(青亭网):谷歌全新3D技术mip-NeRF 360,可合成完整场景和模型